Virtueller Genesys-Agent

Was ist die Herausforderung?

Das Volumen von Contact Centern wächst rasant. Einstellung Agenten Zu Gleichgewicht Dieses Volumen ist teuer und nicht schnell genug. Contact Center möchten Verbrauchern schnell und effizient ein agentenähnliches Erlebnis bieten. Da die Vorlieben der Verbraucher und die zunehmend fortschrittlicheren Self-Service-Optionen dazu führen, dass „einfache“ Fragen nicht mehr im Contact Center gestellt werden, müssen die Agenten komplexe Probleme für Kunden lösen, deren Erwartungen höher sind als je zuvor. . Dies kann zu erhöhten Interaktionsübertragungen führen. Vir T Unsere Mitarbeiter sind für Sie da ! U singen die Macht von G energetisch AI und L Große Sprachmodelle (LLMs) . T hey kann nachahmen ein natürlicheres Gespräch , wie ein Agent , Und kann komplexe Probleme lösen, die auftreten können .

Was ist die Lösung?

Virtual Agent ermöglicht unseren Kunden den autonomen Start, Und vollständig Gespräche in Echtzeit. Der VA wird LLMs verwenden, um zu verstehen, was der Kunde will erreichen , führen Sie sie durch eine Aufgabe im Rahmen eines Geschäftsprozesses oder zeigen Sie die entsprechendes Wissen Artikel, um die Arbeit zu erledigen. Vi R Virtuelle Agenten können sowohl auf Sprach- als auch auf digitalen Kanälen eingesetzt werden und werden alle in einem No-Code-Editor in Genesys Architect erstellt. Virtuelle Agenten können anhand vorhandener Kundentranskripte über das Intent Miner-Tool trainiert werden, um schneller loslegen zu können . Nach Abschluss einer Gespräch , wird generative KI verwendet, um dieselben Aktivitäten nach dem Anruf auszuführen, z. B. das Schreiben einer Zusammenfassung, das Markieren eines Wrap-Codes und das Angeben der nächsten Schritte. KI-gesteuerter Self-Service ermöglicht es Unternehmen, ihre Kundeninteraktionen zu skalieren und gleichzeitig das Erlebnis zu verbessern. Dies wiederum verbessert die Lösungsrate beim ersten Kontakt und reduziert Weiterleitungen.

Übersicht über den Anwendungsfall

Geschichte und Geschäftskontext

Der Aufstieg digitaler und sprachbasierter Kanäle hat zu höheren Kundenerwartungen und einer deutlichen Zunahme des Interaktionsvolumens geführt, das Unternehmen bei der Betreuung ihrer Kunden bewältigen müssen. Da Unternehmen zunehmend auf künstliche Intelligenz (KI) setzen, implementieren viele von ihnen virtuelle Agenten für die Kundeninteraktion. Virtuelle Agenten beantworten Anfragen und automatisieren verschiedene Aufgaben über digitale Plattformen wie Websites, mobile Apps, soziale Medien, SMS und Messaging-Anwendungen hinweg.

Virtuelle Agenten spielen eine entscheidende Rolle bei der Entlastung der Contact-Center-Mitarbeiter, während sie gleichzeitig das allgemeine Kundenerlebnis verbessern und die Kosten effektiv verwalten. Virtuelle Agenten sind rund um die Uhr im Einsatz und bieten sofortige Unterstützung, indem sie Fragen beantworten, Aufgaben ausführen und bei Bedarf nahtlos an einen menschlichen Agenten übergeben.

Der innovative Hybridansatz von Genesys kombiniert Dialog Engine Bot Flows und fortschrittliche Generative AI- und LLM-Technologie und bietet so Kunden und Agenten ein außergewöhnliches Erlebnis. Dieser Hybridansatz bietet das Vertrauen und die Transparenz eines traditionelleren, flussbasierten Erlebnisses und gestaltet die Konversation durch die Verwendung von LLMs flexibler und dynamischer.

Für Kundendienstmitarbeiter sind die Vorteile ebenso beeindruckend. Sie erhalten prägnante Zusammenfassungen der von virtuellen Agenten geführten Gespräche, sodass sie den Kontext schnell erfassen und rasch und präzise auf die Bedürfnisse der Kunden eingehen können. Ähnliche LLMs und generative KI finden sich in Agent Copilot, um die Effizienz der Agenten zu steigern.

Endkunden werden ein neues Serviceniveau erleben, da unsere virtuellen Agenten auf natürliche, gesprächsorientierte Weise antworten. Wenn sie Fragen haben, müssen sie nicht lange Artikel durchsuchen, sondern bekommen Antworten auf ihre spezifische Frage hervorgehoben oder generiert. Unabhängig davon, ob über digitale Kanäle oder per Sprache interagiert wird, verstehen unsere virtuellen Agenten die Kundenbedürfnisse und erfassen wichtige Informationen, um Aufgaben reibungslos zu erledigen.

Wenn ein virtueller Agent ein Gespräch erfolgreich abschließt, schließt er es außerdem genauso ab, wie es ein menschlicher Agent tun würde: Er schreibt eine Zusammenfassung und weist einen Abschlusscode zu, der wertvolle Einblicke in die Leistung bietet. Auf diese Weise können die Beteiligten die Effektivität einfach messen und den Kundenservice kontinuierlich verbessern.

Vorteile im Anwendungsfall

| Nutzen | Erläuterung |

|---|---|

| Verbessertes Kundenerlebnis | Virtual Agent kann komplexere Geschäftsanfragen bearbeiten und Kundenanfragen schneller lösen. |

| Verbesserte Erstkontakt-Auflösung | Reduzieren Sie Wiederholungsanrufe durch eine präzise Lösung beim ersten Mal |

| Reduzierte Transfers | Genauere Identifizierung der Kundenabsicht und Weiterleitung an die richtige Warteschlange |

| Reduzierte Bearbeitungszeit | Kundenanfragen werden in kürzerer Zeit gelöst, da Virtual Agent LLMs verwendet, um hochpräzise Informationen bereitzustellen und die Anfragen so schnell wie möglich zu lösen. |

Zusammenfassung

Genesys Virtual Agents verwenden LL.M.-Studiengänge um Kunden dabei zu unterstützen, die gewünschten Informationen zu finden ok für um ihre Anfragen schnell und mit hoher Genauigkeit zu lösen. Virtuelle Agenten verstehen die Kunden Absicht und bieten schnelle und A genau Antworten . Sie haben T seine Fähigkeit, zusammenfassen A N Antwort von einem einzigen Artikel damit sie adressieren die Kunden Frage direkt , anstatt eine ausführliche Antwort zu geben, die Kunde muss lesen . Virtuelle Agenten bieten ein besseres Kontextverständnis auf menschlicher Ebene als andere Bots sowie mit die Fähigkeit zu halten komplette Gespräche, Stor e der Geschichte und Bestimmungen D t Automatische Nachbearbeitung Codes.

Anwendungsfalldefinition

Geschäftsablauf

- Eine Interaktion wird (reaktiv oder proaktiv) über einen unterstützten Kanal initiiert.

- Der Kunde erhält eine Standard-Willkommensnachricht vom VA.

- Kundeninformationen und/oder Kontext werden abgerufen von:

-

- Kundenprofilinformationen in externen Kontakten

-

- API-Aufruf an eine Drittanbieter-Datenquelle

- Der Kunde erhält eine personalisierte Nachricht oder wird an einen Mitarbeiter weitergeleitet. Beispiele hierfür sind:

-

- Benutzerdefinierte Nachricht oder Update: „Ihre nächste Bestellung wird voraussichtlich am Donnerstag vor 12 Uhr eintreffen.“

-

- Personalisierte Willkommensnachricht: „Hallo Shane, willkommen bei Genesys Cloud. Wie kann ich dir helfen?"

-

- Der Kunde wird direkt an einen Vermittler weitergeleitet, da er einen offenen Betrag schuldet.

- Vorausgesetzt, der Kunde hat die Personalisierungsphase hinter sich gelassen, wird das Gespräch mit dem VA fortgesetzt, der eine offene Frage stellt, wie: „Wie kann ich Ihnen helfen?“, um die Absicht des Kunden zu ermitteln und seine [BL1]

-

- Wenn Absicht und Slots zurückgegeben werden, bewegt sich die Konversation beispielsweise zum richtigen Punkt im Interaktionsfluss;

- „Ich sehe, Sie möchten einen Termin für Freitag buchen, um wie viel Uhr?“

-

- Der VA befolgt weiterhin die Schritte in der Aufgabe, um die Interaktion abzuschließen, indem er:

-

- Sammeln zusätzlicher Informationen und Verwenden von LLMs zum Verständnis verschiedener Antworten

-

- Zeigen Sie einen Wissensartikel an, der sich speziell auf die vorliegende Aufgabe bezieht

-

- Interagieren Sie über eine Datenaktion mit einem Backend-System

- Zeigen Sie einen Artikel aus der Wissensdatenbank an und:

-

- Markieren Sie den relevanten Text im Artikel, um die Frage des Benutzers zu beantworten

-

- Generieren Sie eine personalisierte Antwort mithilfe eines RAG-Modells (Retrieval Augmented Generation).

-

- Übergabe an Live-Agent

- Nach Abschluss einer Aufgabe fragt der VA, ob es Folgemaßnahmen gibt, indem er beispielsweise Folgendes fragt: „Kann ich Ihnen sonst noch behilflich sein?“

-

- Wenn der Kunde mit „Ja“ antwortet, kehrt er zu Schritt 5 zurück: „Wie kann ich Ihnen helfen?“

-

- Wenn der Kunde mit „Nein“ antwortet, kehrt das Gespräch zum Interaktionsfluss zurück.

-

- Wenn der Kunde mit einer ausführlicheren Antwort reagiert, bestimmen Sie die Absicht und die Entitäten für die weitere Verarbeitung.

- Um zu bestimmen, ob eine Umfrage angeboten wird, werden Kundeninformationen und/oder der Kontext abgerufen. [BL2]

-

- Wenn eine Umfrage angeboten wird, werden die Interaktionen an einen Chatbot gesendet.

-

- Wenn keine Umfrage angeboten wird, wird im Interaktionsablauf eine Abschiedsnachricht angezeigt und der Dialog endet

- Die Umfrage wird durchgeführt. Die Fragen der Umfrage sind im Chatbot wie gewohnt durch den Kunden konfigurierbar und daher ist hier kein Dialogablauf definiert.

- Der Interaktionsfluss präsentiert eine Abschiedsnachricht und beendet den Chat

- Der VA schreibt eine Zusammenfassung des Geschehens, markiert alle Abschlusscodes mithilfe eines großen Sprachmodells und übergibt das Gespräch entweder an einen Agenten, der weiterhilft, oder beendet die Interaktion.

Geschäfts- und Vertriebslogik

Geschäftslogik

NLU:

- Absichten: Das Ziel der Interaktion. Beispielsweise leitet die von der NLU zurückgegebene Absicht „Flug buchen“ einen Benutzer zur zugehörigen Aufgabe weiter und führt ihn durch den Vorgang.

- Schlüssel: Zusätzliche wichtige Informationen, die zum Erledigen einer Aufgabe oder Beantworten einer Frage erforderlich sind. Beispielsweise würde „Flug nach Paris buchen“ den Slot für „Reiseziel“ mit dem Schlüsselwort „Paris“ extrahieren. Slots können bei der ersten Anforderung oder bei Bedarf während des gesamten Ablaufs ausgefüllt werden.

LLM:

- Großes Sprachmodell: Die Ausbildung von LLMs erfolgt durch die einfache Beschreibung der zu erledigenden Aufgaben. Beispielsweise hätte die Absicht „Flug buchen“ eine Beschreibung wie „Ein Benutzer möchte einen Flug bei der Fluggesellschaft buchen“, und unabhängig davon, wie ein Benutzer danach fragt, erkennt das LLM, welche Absicht er anfordert.

- LLMs werden auch zum Extrahieren von Slots verwendet. Auch hier reicht es aus, eine Beschreibung wie „Die Stadt, in die der Benutzer fliegen möchte“ einzugeben. Mithilfe seines bereits vorhandenen Wissens über die Welt identifiziert das LLM dann jede vom Benutzer angeforderte Stadt.

- Retrieval Augmented Generation (RAG): Virtuelle Agenten können RAG-Modelle verwenden, um zunächst den richtigen Artikel aus der Wissensdatenbank abzurufen, die Abfrage an das LLM mithilfe des Artikels zu erweitern und eine personalisierte Antwort auf die Frage des Benutzers zu generieren. RAG-Modelle beschränken das Wissen des LLM auf die im Artikel bereitgestellten betriebswirtschaftlichen Inhalte, um eine höhere Genauigkeit und mehr Fachwissen zu erreichen, wahren dabei aber den stark auf Konversation ausgerichteten Charakter eines LLM.

BL1: Agentenübergabe: Der Kunde kann darum bitten, mit einem verfügbaren Agenten verbunden zu werden. An diesem Punkt trennt der virtuelle Agent die Verbindung und das Chat-Protokoll (ohne vertrauliche Daten) wird auf dem Agent-Desktop angezeigt. Der VA sendet außerdem eine Zusammenfassung des bisherigen Gesprächs.

BL2: Umfrage: Der Kunde kann selbst bestimmen, ob er an einer Umfrage teilnehmen möchte oder nicht. Diese Umfrage kann basieren auf:

- Kundenprofilinformationen in externen Kontakten

- Customer-Journey-Daten

- API-Aufruf an eine Drittanbieter-Datenquelle

Benutzeroberfläche und Berichterstellung

Agenten-ID

Chatprotokoll zwischen Kunde und Virtueller Agent wird im Chat-Interaktionsfenster auf dem Agent-Desktop angezeigt. Die Zusammenfassung wird im Interaktionsbereich angezeigt.

Berichterstellung

Echtzeit-Reporting

Mit Genesys Cloud können Sie Flow-Berichte erstellen und Flow-Ergebnisse verwenden, um über VA- und Bot-Flow-Absichten zu berichten.

Sehen Sie sich die Ansicht „Flows-Leistungsübersicht“ und Verwendung Flow-Ergebnis Statistiken, die Ihnen dabei helfen, Leistungsprobleme für bestimmte VA- und Bot-Flows zu ermitteln und Daten zum Self-Service-Erfolg zu sammeln. Verwenden Sie die VA- und Bot-Flow-Flussdaten, um die Ergebnisse zu verbessern. Notiz: Für die Erstellung von Flow-Ergebnisstatistiken ist die Implementierung von Flow-Ergebnissen durch den Kunden erforderlich.

Verwenden Sie die Flows Performance Detailansicht um eine Aufschlüsselung der Metriken nach Intervall für einen bestimmten VA- und Bot-Flow-Flow anzuzeigen und um zu sehen, wie VA- und Bot-Flow-Interaktionen in einen Chat-Flow eintreten und ihn verlassen.

Der Ansicht „Zusammenfassung der Flow-Ergebnisse“ zeigt Statistiken zu Chats an, die in Architect-Flows gelangen. Mithilfe dieser Statistiken können Sie ermitteln, wie gut Ihre VA- und Bot-Flow-Flows den Kunden dienen, und Daten zum Erfolg des Self-Service sammeln.

Historische Berichterstattung

Im Knowledge Optimizer-Dashboard können Sie die Effektivität Ihrer Wissensdatenbank analysieren. In dieser Ansicht können Sie die folgenden Kennzahlen sehen:

- Alle Anfragen in einem bestimmten Zeitraum und die prozentuale Aufschlüsselung der beantworteten und unbeantworteten Anfragen.

- Alle beantworteten Anfragen in einem bestimmten Zeitraum und die prozentuale Aufschlüsselung der Anwendung, aus der die Konversation stammt.

- Alle unbeantworteten Anfragen in einem bestimmten Zeitraum und die prozentuale Aufschlüsselung der Anwendung, aus der die Konversation stammt.

- Top-20-Artikel und die Häufigkeit, mit der ein Artikel in einer Konversation vorkam.

- Die 20 am häufigsten beantworteten Fragen und die Häufigkeit, mit der jede beantwortete Frage in einer Konversation vorkam.

- Die 20 am häufigsten unbeantworteten Fragen und die Häufigkeit, mit der jede unbeantwortete Frage in einer Konversation vorkam.

sehen Wissensoptimierer

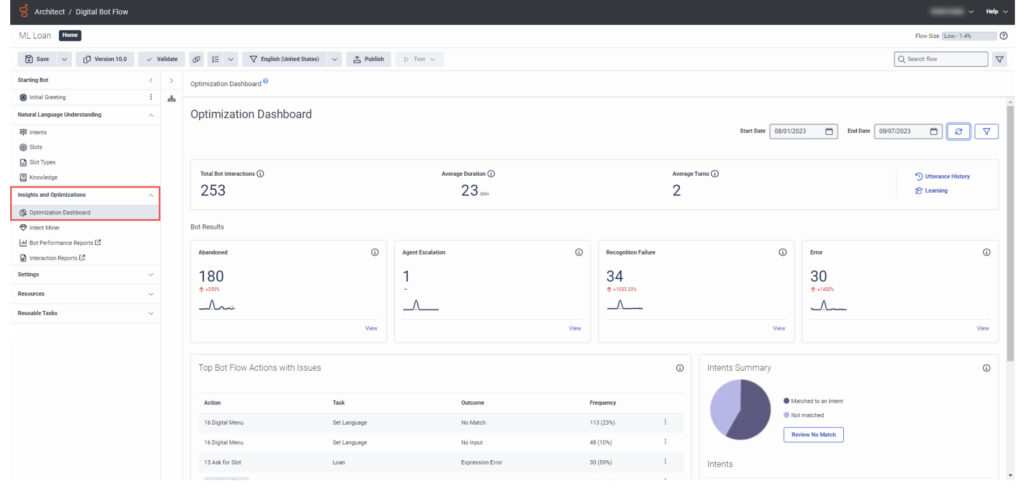

Das Bot Optimizer Dashboard Mit Architect können Sie die Leistung und Betriebsmetriken auf hoher Ebene für einen ausgewählten Genesys Dialog Engine Bot Flow oder Genesys Digital Bot Flow anzeigen. Diese Daten helfen Ihnen bei der Verbesserung und Fehlerbehebung Ihrer VA und Bot Flow . Sie können diese Ergebnisse auch filtern, indem Sie einen Datumsbereich oder eine konfigurierte Sprache angeben.

Überlegungen für den Kunden

Wechselwirkungen

Allgemeine Annahmen

Kunden und/oder Genesys Professional Services sind verantwortlich für Verwalten des Virtual Agent NLU, der Regel-Engine und Hochladen der eigenen Wissensdatenbank Artikel in Genesys Knowledge Workbench zur Verwendung durch Virtual Agent .

Verantwortlichkeiten der Kunden

- Der Kunde muss eine KB oder die Artikel bereitstellen, die die Elemente der Wissensdatenbank bilden.

- Für die Funktionen zur Flow-Ergebnisstatistik muss der Kunde Flow-Ergebnisse implementieren. Sie sind nicht sofort einsatzbereit.

Dazugehörige Dokumentation

Dokumentversion

V 1.0.0